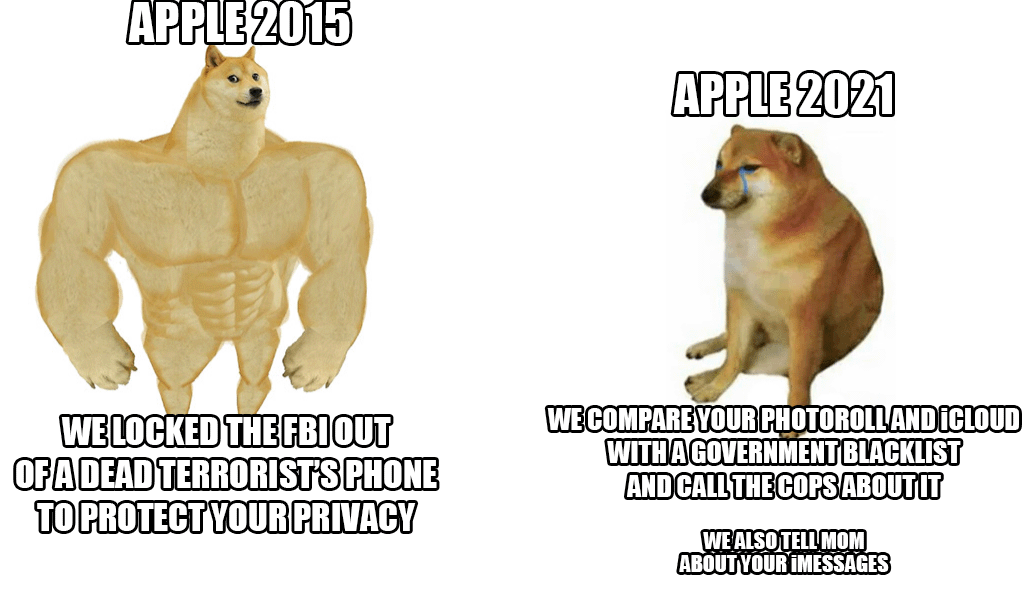

Joan den astearen amaieran, Applek haurren aurkako tratu txarren aurkako sistema berri bat aurkeztu zuen, ia guztion iCloud argazkiak eskaneatzen dituena. Lehen begiratuan ideia ona dirudien arren, haurrak ekintza honetatik babestu behar direlako, Cupertinoko erraldoia elur-jausi batek kritikatu zuen, erabiltzaileek eta segurtasun-adituek ez ezik, langileek ere bai.

Agentzia errespetatu baten azken informazioaren arabera Reuters hainbat langilek sistema honen inguruko kezkak adierazi zituzten Slack-eko barne komunikazio batean. Ustez, agintariek eta gobernuek egin ditzaketen gehiegikerien beldur izan beharko lukete, aukera horiek abusu ditzaketenak, adibidez, pertsonak edo talde hautatuak zentsuratzeko. Sistemaren agerpenak eztabaida handia piztu zuen, dagoeneko 800 mezu indibidual baino gehiago dituena aipatutako Slack-en barruan. Laburbilduz, langileak kezkatuta daude. Segurtasun adituek ere aurretik jarri dute arreta, okerreko eskuetan aktibistak, aipatu zentsura eta antzekoak zapaltzeko erabilitako arma benetan arriskutsua izango litzatekeela.

Berri ona (orain arte) berritasuna Estatu Batuetan baino ez dela hasiko da. Momentuz, ez dago argi ere sistema Europar Batasuneko estatuen barruan ere erabiliko den. Dena den, kritika guztiak gorabehera, Applek bere horretan jartzen du eta sistema defendatzen du. Batez ere egiaztapen guztiak gailuaren barruan egiten direla eta behin partida bat dagoenean, une horretan soilik Appleko langile batek kasua berriro egiaztatzen duela dio. Bere diskrezioan bakarrik emango zaie dagokion agintariei.

Izan liteke interesatzen zaizu

Gorroto nuke iCloudetik zerbait seguru eta benetan pribatu batera aldatzea, baina Applek tematzen badu, hala ere ordaintzeari utziko diot.

AEBetan bakarrik egongo da aktibo (oraingoz).

Berdin dio non aplikatuko den legegintzaldian. Teknologia hori dagoeneko kanpoan egongo da eta zabalduta egongo da. Hori da arriskurik handiena.